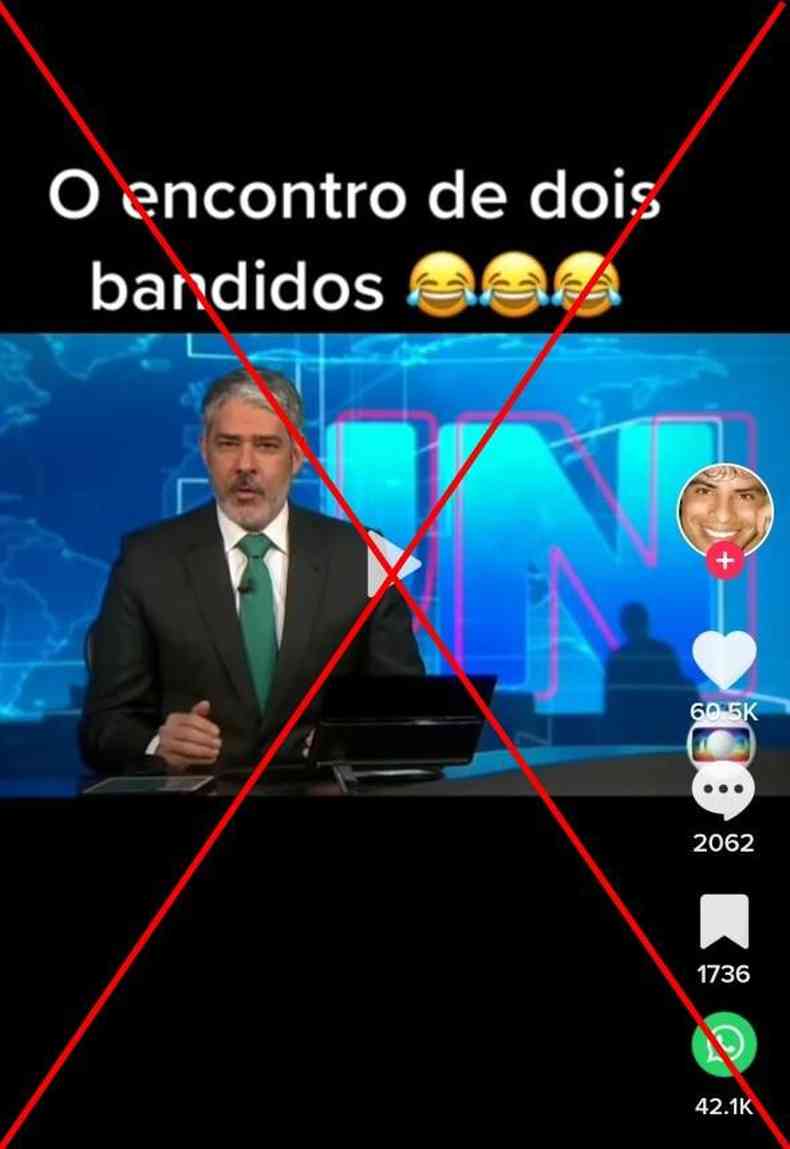

O vídeo de 14 segundos começa com uma tela preta com os dizeres 'O encontro de dois bandidos' e emojis de risada. Em seguida, vê-se a abertura do Jornal Nacional, da TV Globo, com a narração de William Bonner repetindo essa frase. A gravação, então, corta para imagens de Lula e Alckmin se abraçando, enquanto o jornalista parece falar: 'Perdão, imagem errada. A imagem seria de outro ladrão, digo, de um ladrão de verdade'.

O conteúdo circula no TikTok (1, 2), Kwai (1, 2), Twitter (1, 2) e Facebook.

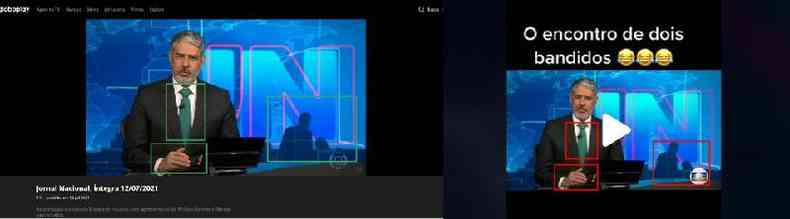

No entanto, uma busca reversa pela imagem de Bonner permitiu encontrar o vídeo original. Trata-se de uma edição do Jornal Nacional de 12 de julho de 2021 e a reportagem chamada por Bonner, aos 10 minutos e 49 segundos, era sobre o arquivamento pela Justiça Eleitoral de São Paulo de uma das ações da Lava Jato contra Delúbio Soares, ex-tesoureiro do PT. Em nenhum momento Bonner menciona Lula ou Alckmin.

Nessa versão do vídeo - sem os supostos xingamentos contra os dois políticos - os movimentos faciais e labiais do apresentador coincidem com o que é dito, ao contrário do que acontece na gravação compartilhada nas redes.

Já a imagem de Lula e Alckmin se abraçando, vista a partir de oito segundos do conteúdo viral, data de 14 de abril de 2022, em um evento com centrais sindicais em São Paulo. A publicação no TikTok usou um vídeo da reportagem do UOL Notícias sobre o fato.

Deepfake de áudio

Procurado pelo Comprova, projeto de verificação colaborativa do qual o AFP Checamos faz parte, o jornalista e produtor de deepfakes humorísticas Bruno Sartori explicou que a voz atribuída a Bonner foi produzida a partir da técnica Text to Speech (TTS), que gera áudios sinteticamente a partir de um conteúdo em texto.

O deepfake é uma tecnologia que manipula áudio e vídeos por meio de ferramentas de inteligência artificial.

Sartori exemplificou ainda que a técnica utilizada pelo autor do vídeo analisado foi similar à que ele usou em um conteúdo com a voz da ex-presidente Dilma Rousseff. 'A partir de um banco com dezenas de áudios do William Bonner falando, o computador gera um novo áudio, do zero, baseado no que foi escrito em texto', acrescentou.

Ainda de acordo com Sartori, já existem sites disponíveis ao público capazes de produzir áudios sintéticos de pessoas famosas a partir de conteúdos em texto.

O cientista da computação Anderson de Rezende Rocha, diretor do Instituto de Computação da Unicamp, explica que as falsificações já existem há bastante tempo, a grande mudança é que agora esses conteúdos são criados por inteligência artificial, e não por um ser humano.

'A inteligência artificial permite que você consiga criar falsificações sem precisar da supervisão de um humano, que é substituído por uma técnica chamada 'generative adversarial network' (rede adversarial regenerativa, uma rede de inteligência artificial). Essa rede normalmente tem muitas camadas e parâmetros, e justamente daí sai o nome 'deep' [profundo, em inglês]. 'Deepfake' então vem da criação de conteúdo a partir de redes desse tipo, tanto para áudio quanto para vídeo e imagem', assinala.

Esse texto faz parte do Projeto Comprova. Participaram jornalistas da revista piauí e d'O Plural. O material foi adaptado pelo AFP Checamos.