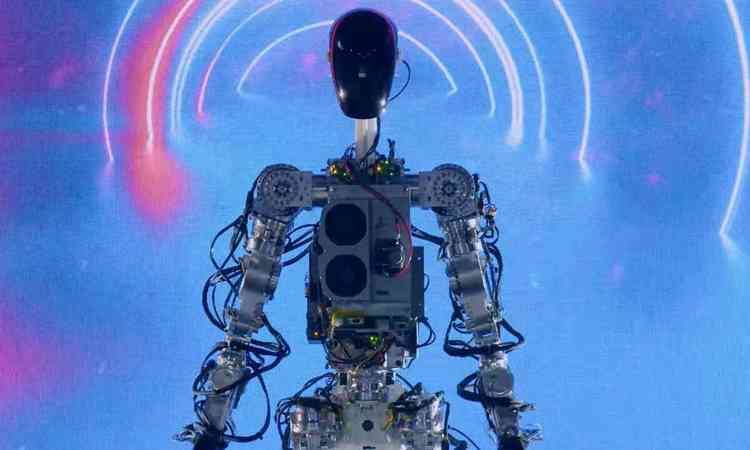

Os testes avaliaram o GPT-3.5, a tecnologia da versão original do ChatGPT, usando ferramentas de análise de desempenho feitas pela OpenAI, criadora do robô

Se fosse um aluno, o ChatGPT teria uma pontuação média de 612,3 nas provas objetivas do Enem (Exame Nacional do Ensino Médio). Ele se sairia melhor do que 98,9% dos estudantes em ciências humanas e do que 95,3% em linguagens e códigos. No geral, superaria 78,9% dos candidatos.

Os dados são de análise do DeltaFolha feita com base nas respostas da inteligência artificial (IA) em provas realizadas em cinco anos, de 2017 a 2021, a mais recente com pontuações individuais disponíveis publicamente, o que permite calcular a nota final do robô em cada área do conhecimento.

O ChatGPT respondeu a 1.290 questões. É um raro exemplo de estudo nessa escala avaliando a tecnologia em português.

Em relação a 2020 e 2021, foram consideradas as duas aplicações do exame em cada ano, que têm perguntas totalmente diferentes entre si.

O resultado do Enem não corresponde exatamente ao percentual de perguntas certas. Acertar questões difíceis e errar fáceis, por exemplo, pode ser entendido como chute, e isso reflete na nota final. A análise da reportagem reproduziu esse cálculo, a fim de comparar diretamente a desenvoltura entre humanos e a IA.

Os testes avaliaram o GPT-3.5, a tecnologia da versão original do ChatGPT, usando ferramentas de análise de desempenho feitas pela OpenAI, criadora do robô.

Para a primeira aplicação da prova de 2021, a reportagem pediu que o sistema fizesse uma redação seguindo o mesmo enunciado da prova. Para simular a metodologia do Ministério da Educação, o texto foi corrigido por dois especialistas que utilizaram critérios do Enem. A nota média do robô foi 700 -melhor do que 68% dos estudantes, que tiveram 613 em média.

Somando a nota da redação à média das provas objetivas em 2021 (726,8 em ciências humanas, 606,2 em linguagens e códigos, 577 em ciências da natureza e 433,6 em matemática), a nota do ChatGPT no Enem foi 608,7.

O resultado é melhor do que o obtido por 79% dos alunos naquele ano -a média foi 535. Seria suficiente para garantir acesso a cursos como serviço social na Universidade Federal de Pernambuco e ciências sociais na Universidade Federal Fluminense.

A avaliação considerou o cálculo que cada curso adota (o peso das disciplinas diverge a depender da graduação). A nota garantiria, de acordo com o Sisu (Sistema de Seleção Unificada), o ingresso em 63 das 938 opções listadas por dez das universidades federais mais bem colocadas no Ranking Universitário Folha de 2019.

As ciências humanas foram o ponto forte da IA. A média das notas dos cinco anos foi de 725,3, superior à de 523,3 pontos dos estudantes. Em 2017, com a melhor nota (785,3), o robô foi superado por somente 775 candidatos (entre 4,7 milhões).

O ChatGPT superou os concorrentes orgânicos também nas áreas de linguagem e de ciências naturais. A nota média foi de 641,4 (ante 516,1) e de 639,2 (ante 492,5), respectivamente.

Na comparação, os resultados nas provas de matemática são quase desoladores. Em média, o robô acumulou 443,1 pontos, abaixo dos 527,1 obtidos por candidatos reais. Acertou entre 13,6% e 27,3% das questões em cada aplicação -alguém que chutasse todas as respostas deveria acertar algo como 20%.

Um artigo científico divulgado na última quarta-feira (29) fez uma análise semelhante à da reportagem. Nele, pesquisadores das universidades de São Paulo (USP), São Francisco (USF) e Campinas (Unicamp) chegaram a um padrão de desempenho parecido, com notas sofridas em matemática.

Para Ricardo Primi, um dos autores, uma possível explicação é que essas questões exigem que o robô extraia as informações da pergunta e siga uma linha de raciocínio, como montar a conta necessária, para chegar à resposta. No caso de humanas e linguagens, basta acessar dados que ele já tenha visto, sem precisar executar nada.

No estudo do grupo, o resultado melhorou com uma indução ao GPT -quando, em vez de apenas perguntar e esperar a réplica, os pesquisadores deram alguns exemplos de questões respondidas antes. Os acertos subiram ainda mais quando pediram que a tecnologia justificasse as respostas.

"Quando se apresenta um problema em texto, talvez ele não tenha esse mesmo dado no processo de treinamento. Ele não viu os padrões dos passos do raciocínio explicitamente", diz Primi.

A disciplina aparece como calcanhar de Aquiles do sistema desde o seu lançamento. A OpenAI chegou a anunciar melhorias na área no fim de janeiro.

Em março, a empresa lançou uma atualização desse sistema, o GPT-4, mas ela ainda não está amplamente disponível. Nos testes oficiais, a nova versão mostrou desempenho melhor do que a antiga em provas criadas para humanos em relação ao antecessor.

REDAÇÃO

No teste de redação, a reportagem passou ao robô a mesma instrução do Enem, utilizando como exemplo a prova de 2021. O enunciado pedia um texto dissertativo-argumentativo sobre "invisibilidade e registro civil: garantia de acesso à cidadania no Brasil".

O Enem considera cinco competências para avaliação textual. De cara, os dois especialistas consultados ressaltaram que o texto ultrapassaria as 30 linhas permitidas.

Segundo Adriano Chan, que deu à redação do ChatGPT nota 760, o texto foi coeso, mas deixou a desejar nos demais itens. O professor aponta que o robô pecou em vírgulas e na construção sintática, mostrou pouco repertório sociocultural, falhou em argumentar com dados concretos e em propor uma intervenção para resolver o problema.

A correção da professora Jéssica Dorta identificou problemas semelhantes, com uma nota de 640. Ela tirou mais pontos por falta de coesão e descontou pelas propostas de intervenção.

METODOLOGIA

O modelo matemático adotado pelo Enem, a Teoria de Resposta ao Item, prevê itens calibrados conforme parâmetros de discriminação (se diferencia os candidatos de acordo com o nível de conhecimento naquele tema), dificuldade e probabilidade de acerto casual. Além do número de acertos, o cálculo considera quais perguntas foram respondidas corretamente.

Para chegar à nota final do ChatGPT, a reportagem reproduziu essa metodologia com base nos dados do Inep (Instituto Nacional de Estudos e Pesquisas Educacionais).

Por meio de uma interface para programadores, o robô respondeu a cada pergunta apenas uma vez, indicando a alternativa que julgava correta, sem exemplo prévio. Como a tecnologia não interpreta imagens, foram usadas as versões do Enem de ledor, que são lidas em voz alta para candidatos com dificuldades visuais, com as descrições oficiais de fotos e gráficos.

O GPT também foi configurado para ser o menos criativo possível nas respostas, a fim de limitar eventuais "divagações". A alternativa escolhida foi extraída das réplicas do robô.

Sistemas de linguagem como o GPT funcionam a partir de treinamento: são alimentados com bilhões de dados textuais, dos quais extraem padrões de encadeamento de palavras. Nesse processo, o robô pode já ter visto algumas das questões das provas aplicadas.

Os dados conhecidos pelo ChatGPT datam até setembro de 2021, ou seja, há uma chance de ele já ter se deparado com perguntas e respostas de quatro edições do Enem testadas. O fenômeno, chamado de contaminação, no entanto, parece ter efeito limitado.

Ao divulgar o GPT-4, pesquisadores ligados à OpenAI puseram a ferramenta para resolver uma série de provas, como o SAT (espécie de Enem americano) e o teste para se tornar advogado nos EUA. Constataram que a contaminação pouco impactava o resultado final: a nota era parecida mesmo desconsiderando as perguntas que a IA conhecia de antemão.

Uma análise do Enem removendo os conteúdos contaminados é impossível, já que a OpenAI não abre ao público quais foram os textos usados no processo de treinamento da máquina. No teste brasileiro, os resultados das provas mais antigas foram semelhantes ao desempenho na prova mais recente.

*Para comentar, faça seu login ou assine